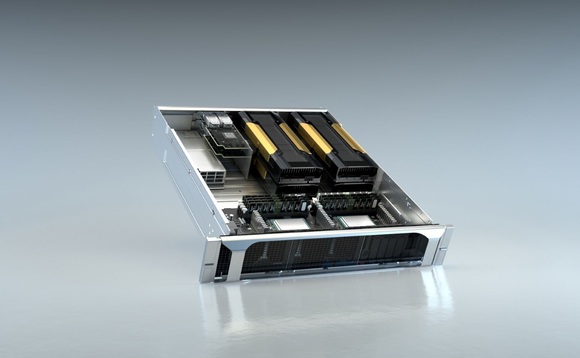

La piattaforma di supercomputer Nvidia EGX Edge è basata su cloud e combina GPU e dispositivi certificati con il software CUDA-X

Il fine di Nvidia EGX Edge è creare un sistema in grado di elaborare e processare grandi quantità di dati. Per la sua natura scalabile, il sistema riesce ad arrivare a 1,6 TB al secondo, e non è un’impresa da poco. Aziende come BMW, Samsung e Walmart già utilizzano la piattaforma, progettata per acquisire dati in streaming da dispositivi IoT posti ai margini della rete; ad esempio, robot e sensori.

Come funziona il sistema

Walmart sta usando la potenza di calcolo per avvisare i dipendenti quando gli scaffali hanno bisogno di rifornimento e checkout, mentre BMW li sfrutta per filtrare i dati di sensori e telecamere nel suo processo di produzione, per automatizzare l’ispezione dei veicoli. Samsung invece si baserà sulla piattaforma per aiutare la sua progettazione di semiconduttori e la successiva produzione.

Le innovazioni apportate alla tecnologia EGX Edge potrebbero alla fine essere utili per concretizzare le apparecchiature di IA, come ad esempio la guida autonoma di Nvidia ma è tutto da scoprire. D’altra parte, essere in grado di ridurre un sacco di dati utilizzando la tecnologia basata su GPU potrebbe dipingere un futuro di schede grafiche con potenziali masse di larghezza di banda per rendering notevolmente migliorati.

“Siamo entrati in una nuova era, dove miliardi di sensori IoT sempre attivi saranno collegati al 5G e elaborati dall’IA. Le basi richiedono una nuova classe di computer di rete altamente sicuri operati con semplicità da remoto. Abbiamo creato Nvidia EGX Supercomputing Platform per questo mondo, dove l’elaborazione va oltre e funziona su scala gobale” ha dichiarato Jensen Huang, fondatore e Ceo di Nvidia.